Silva Ferretti is a freelance consultant with extensive international experience in both development and humanitarian work. She has been working with diverse organizations, committees, networks and consortia (e.g. Agire, ActionAid, CDAC, DEC, ECB project, Handicap International, HAP, Plan International, Save the Children, SPHERE, Unicef, WorldVision amongst many others).

Her work is mainly focused on looking at the quality of programs and on improving their accountability and responsiveness to the needs, capacities and aspirations of the affected populations.

Her work has included impact evaluations / documentation of programs; set up of toolkits, methodologies, standards, frameworks and guidelines; coaching, training and facilitation; field research and assessments.

Within all her work Silva emphasizes participatory approaches and learning. She has a solid academic background, and also collaborated with academic and research institutions in short workshops on a broad range of topics (including: innovations in impact evaluation, Disaster Risk Management, participatory methodologies, protection, communication with affected populations).

She emphasizes innovation in her work, such as the use of visuals and videos in gathering and presenting information.

Silva Ferretti

Freelance consultantBonjour Yosi, merci pour cette question très importante !

Je suis en train de rassembler quelques conseils sur l'inclusion des questions environnementales dans l'évaluation. Ci-dessous est l'un d'entre eux (en anglais, traducion en desssous). J'espère en partager d'autres.

Vous voyez, un "environnement de réflexion" est un état d'esprit.

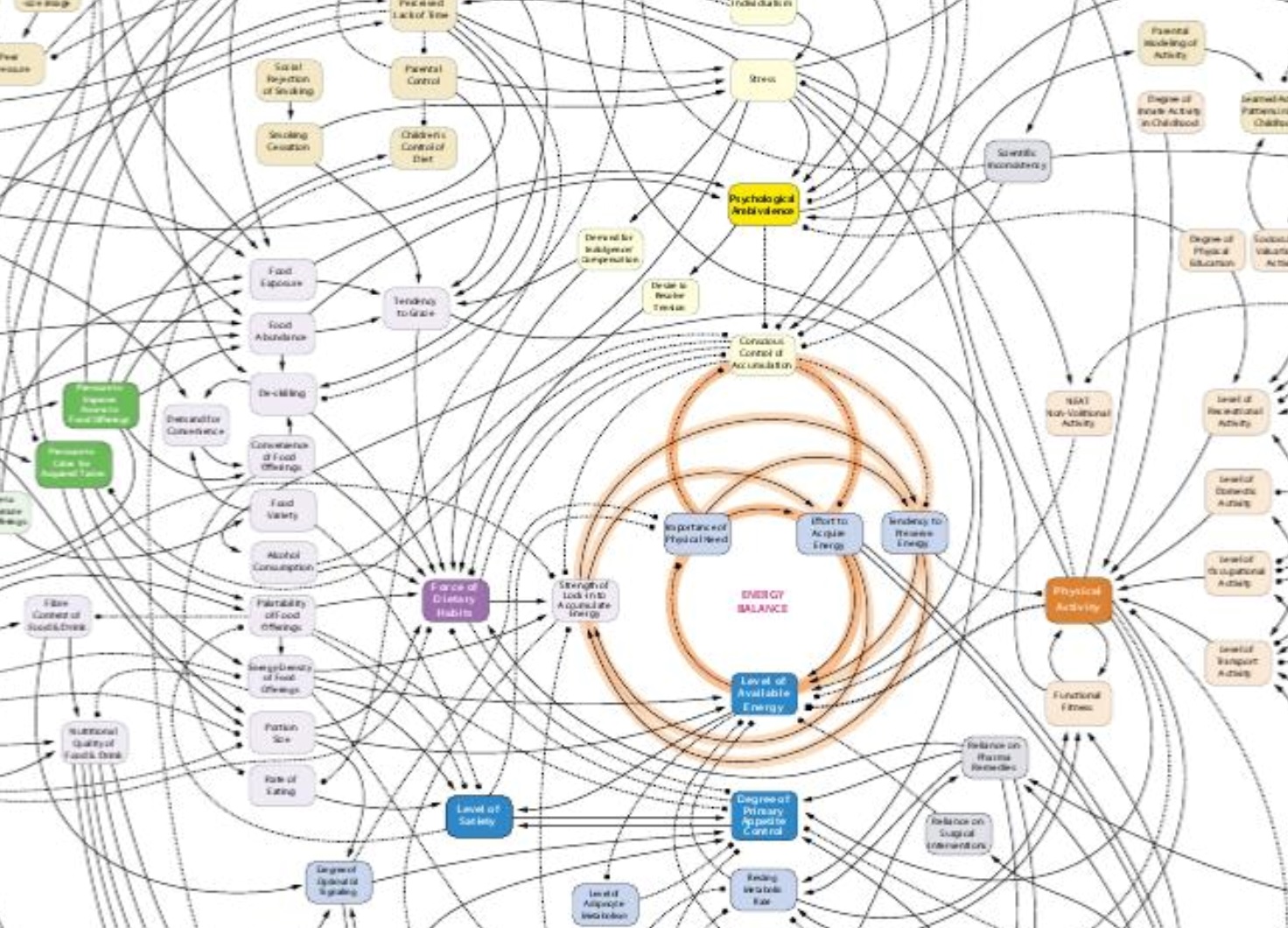

Dès que nous adoptons une perspective plus écosystémique, nous constatons immédiatement les limites de nos approches.

Mais nous découvrons aussi que des choses simples - comme une question supplémentaire - peuvent faire beaucoup :-)

Poser la question supplémentaire

Vérifier si les produits et les résultats obtenus sont susceptibles d'avoir des effets négatifs à long terme.

Ce qui ressemble à une réussite *aujourd'hui* peut épuiser l'environnement à long terme.

Les effets négatifs peuvent n'être révélés que trop tard !

Lorsque nous ne portons pas de lunettes environnementales, il est facile de se laisser emporter par les réalisations. Souvent, les termes de référence et les critères ne nous poussent pas à poser la question suivante :

comment les résultats affectent-ils l'écosystème aujourd'hui ? Et quel est l'impact à long terme ?