Silva Ferretti is a freelance consultant with extensive international experience in both development and humanitarian work. She has been working with diverse organizations, committees, networks and consortia (e.g. Agire, ActionAid, CDAC, DEC, ECB project, Handicap International, HAP, Plan International, Save the Children, SPHERE, Unicef, WorldVision amongst many others).

Her work is mainly focused on looking at the quality of programs and on improving their accountability and responsiveness to the needs, capacities and aspirations of the affected populations.

Her work has included impact evaluations / documentation of programs; set up of toolkits, methodologies, standards, frameworks and guidelines; coaching, training and facilitation; field research and assessments.

Within all her work Silva emphasizes participatory approaches and learning. She has a solid academic background, and also collaborated with academic and research institutions in short workshops on a broad range of topics (including: innovations in impact evaluation, Disaster Risk Management, participatory methodologies, protection, communication with affected populations).

She emphasizes innovation in her work, such as the use of visuals and videos in gathering and presenting information.

Silva Ferretti

Freelance consultantHola Yosi, ¡gracias por esta pregunta tan importante!

Estoy recopilando algunos consejos para incluir las cuestiones medioambientales en la evaluación. Aquí tienes uno de ellos (en inglés, traducción a continuación). Espero compartir más.

Verás, un "entorno de pensamiento" es una mentalidad.

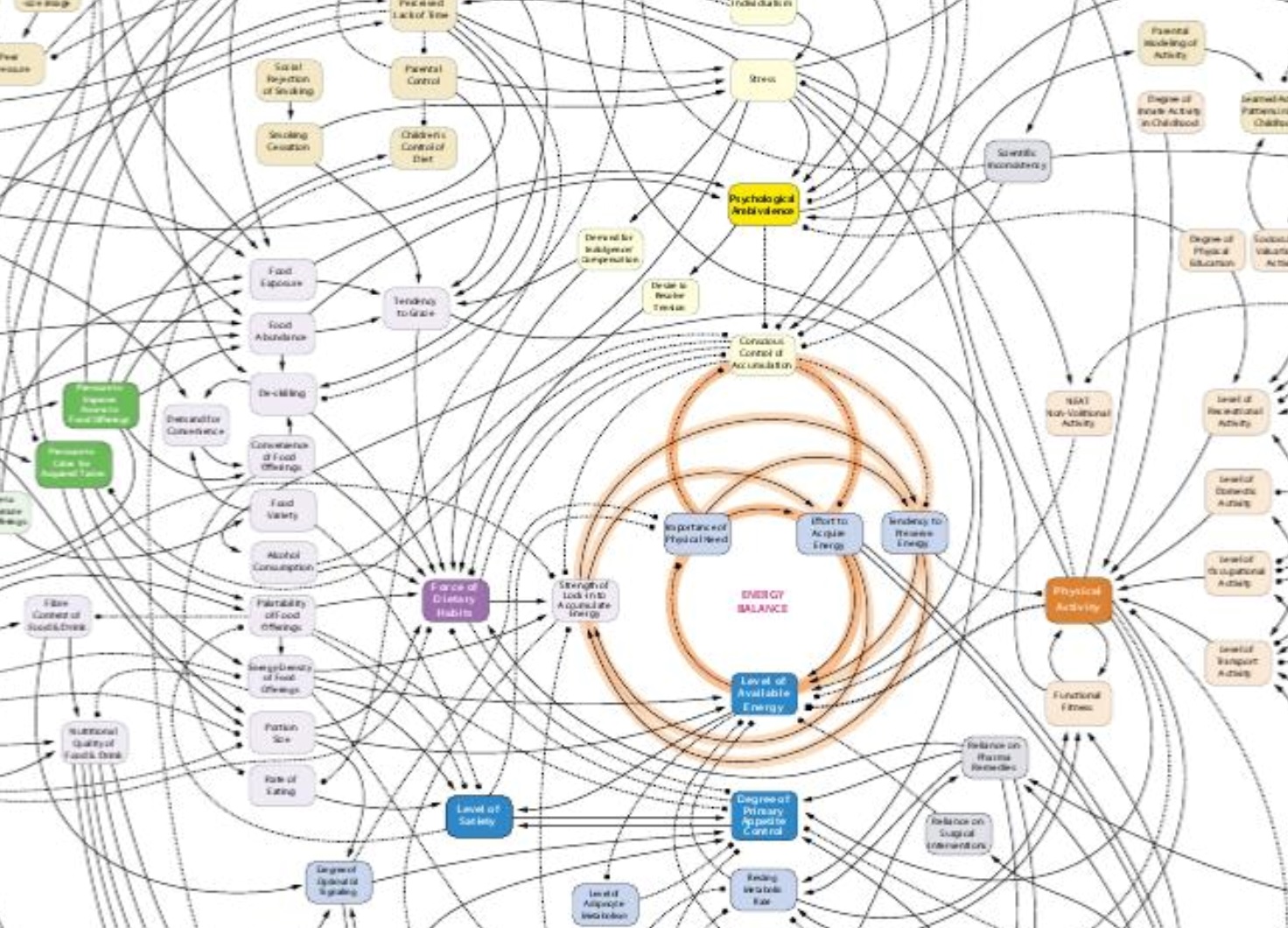

En el momento en que adoptamos una perspectiva más ecosistémica, nos damos cuenta inmediatamente de las limitaciones de nuestros planteamientos.

Pero también descubrimos que cosas sencillas -como una pregunta más- pueden llegar muy lejos. :-)

hacer la pregunta extra

Compruebe si los resultados y productos exitosos pueden tener efectos negativos a largo plazo.

Lo que parece un éxito *ahora* puede agotar el medio ambiente a largo plazo.

Es posible que los efectos negativos no se descubran hasta que sea demasiado tarde.

Cuando no llevamos gafas ecológicas, es fácil dejarse llevar por los logros. A menudo, los términos de referencia y los criterios no nos empujan a hacernos la siguiente pregunta:

¿cómo están afectando ahora los resultados al ecosistema? ¿Y el impacto o impactos a largo plazo?