L’intelligence artificielle est-elle suffisamment ingénieuse pour faciliter notre travail d'évaluation et jusqu'où pouvons-nous l’utiliser?

Les évaluateurs sont des interprètes. Les conversations avec de vraies personnes, sur le terrain, se tiennent dans le langage simple de tous les jours. Les évaluateurs les traduisent dans le jargon utilisé dans les discussions et les rapports sur le développement (où les personnes sont "responsabilisées", "informées", "mobilisées", "créent des plateformes" ou "revendiquent leurs droits"), pour les rendre plus adaptées à l'analyse et au partage.

Lorsque j'ai commencé à utiliser des vidéos dans mon travail – en enregistrant des extraits de ces conversations – j'ai découvert à quel point les professionnels du développement et de l'humanitaire, peu exposés à la réalité du terrain (et trop souvent habitués au jargon), peuvent être déconcertés par la simplicité du langage de tous les jours et ne pas en saisir le sens.

Une vidéo présentait par exemple une femme bénéficiaire d'un projet sur l'eau. L'eau arrivait maintenant près de chez elle et non à des kilomètres. En réponse à une question sur le changement qu'elle avait vécu grâce à ces nouveaux puits, elle a montré fièrement le café qu'elle prenait avec d'autres femmes et plaisanté: "Maintenant j'ai le temps de boire un café avec mes amies!" Elle n'a pas parlé des corvées. Elle se réjouissait de son temps libre et de sa vie sociale. Un résultat merveilleux et inattendu. Mais ... cette vidéo tombait à plat. On m'a demandé: "Quel est le rapport entre un café et un projet sur l'eau?!" Et ce n'était pas un commentaire isolé. Les changements "soft" sont souvent difficiles à saisir et à évaluer. Le changement est révélé par la traduction alors qu'il serait perdu dans les mots de tous les jours. Il peut également être apprécié davantage lorsqu'il est traduit en jargon.

Donc, c'est bien vrai, les évaluateurs doivent être des interprètes et lire entre les lignes. Ils doivent traduire les réalisations et les défis dans le jargon utilisé par la communauté du développement et de l'humanitaire, afin que les changements significatifs puissent être évalués et appréciés, mais aussi pour la commodité de l'analyse.

J'ai été pris de curiosité: est-ce que l'intelligence artificielle le comprendrait? Pourrait-elle être un bon interprète?

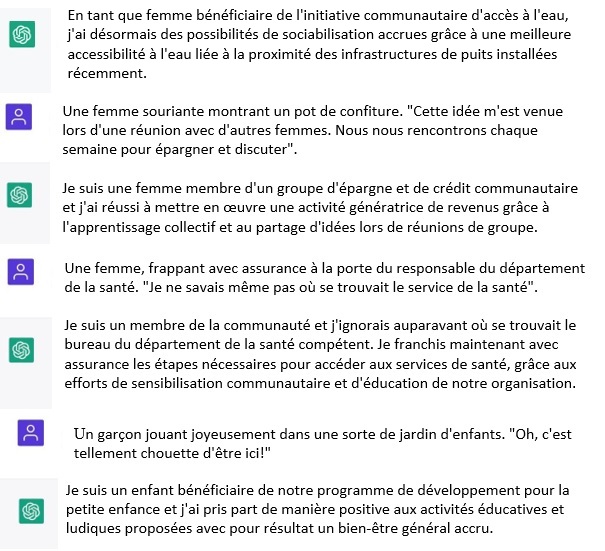

J'ai demandé à ChatGPT de traduire des phrases simples dans le jargon de l'humanitaire/du développement:

"Jouons à un jeu. Imagine un praticien/bureaucrate du développement aguerri qui ne comprend que la langue des experts, le jargon, les propositions de projet et le langage des rapports. Cette personne ne comprend pas les phrases de la langue parlée. Je vais maintenant te présenter des phrases énoncées par des personnes du monde réel. J'ai besoin que tu les traduises pour le praticien dans le jargon du développement. Est-ce clair?

"Tout à fait" m'a répondu ChatGPT avec assurance!

Et en effet, il y est parvenu.

ChatGPT pourrait aller encore plus loin. Je lui ai demandé de vérifier si et de quelle manière ces phrases répondaient à des critères préétablis. Il a été excellent dans cette tâche (et il pouvait également proposer des formats adaptés à l'exportation sur Excel). Mais je garde ce sujet pour un autre article!

Que nous reste-t-il alors?

Tout d'abord, obtenir les phrases.

Les phrases utilisées en exemples sont le résultat d'une implication humaine: être là, instaurer la confiance, reconnaître un tournant particulier dans la conversation et s'y engager avec curiosité et une écoute active. ChatGPT est très fort pour traduire les phrases mais ne l'est pas (encore?) pour mener des conversations ou saisir ce qui est le plus important. Ceci étant, les instruments d'intelligence artificielle peuvent déjà nous offrir une bonne liste de questions standard. Des chatbots connectés peuvent faciliter et analyser les conversations libres sur des sujets prédéterminés. Mais il leur manque encore certainement la présence, l'instinct, la relation qui peuvent transformer une session de questions-réponses en une conversation. Il leur manque également les émotions qui déterminent en fin de compte les conversations et la confiance.

Découvrir les critères émergents.

L'analyse qualitative peut débuter à partir de critères préétablis: nous pouvons vérifier si/de quelle manière les éléments de preuves y répondent. Les critères d'évaluation standard et les questions d'évaluation définies peuvent être examinés à travers ce type d'analyse déductive. Cette approche fonctionne bien lorsque nous savons déjà ce que nous recherchons. L'analyse qualitative peut aussi être utilisée pour mettre à jour des modèles, des thèmes, des idées qui n'apparaissaient pas initialement. L'analyse qualitative inductive est, elle, une approche complètement différente: elle est davantage exploratoire et ouverte à la possibilité de constatations inattendues. ChatGPT peut également chercher les critères émergents, mais l'identification de ces critères et des éléments de preuve demande beaucoup de doigté. ChatGPT cherche des modèles, ce qui est statistiquement récurrent. Ce faisant, il pourrait nous aider à révéler nos propres biais. Les humains utilisent également leur curiosité, leur intuition, leur recherche de sens et les indices non textuels pour découvrir ce qui ressort, les écarts, les lacunes. Leur subjectivité et leur intuition fonctionnent mieux dans des contextes complexes. Comme ChatGPT l'énonce, "si les données sont structurées et de nature quantitative, ma capacité à identifier des critères émergents pourrait être plus limitée... certains types de critères pourraient s'avérer plus difficiles à identifier pour moi. Par exemple, je pourrais avoir du mal à identifier des phénomènes sociaux ou culturels complexes qui exigent une profonde compréhension d'un contexte ou une expertise sectorielle."

Identifier les idées innovantes.

En relation avec ce qui a été mentionné précédemment, ChatGPT pourrait rapidement comprendre qu'un groupe est un groupe "d'entraide" ... mais il aurait du mal à découvrir ce qui rend ce groupe unique ou ses défis et son potentiel inexprimés. Les évaluateurs expérimentés peuvent au contraire lire tout cela entre les lignes (et se renseigner davantage). En se focalisant ainsi sur les tendances et les modèles explicites, ChatGPT risque d'aplatir les récits. Alors qu'il pourrait émettre toute sorte d'idées génériques au pied levé, il a beaucoup plus de mal à révéler les vrais germes de l'innovation: cela demande d'être en phase et connecté avec la réalité. Nous sommes encore bien meilleurs pour trouver ce qui est unique, pour pressentir de nouvelles directions (et oui, ChatGPT est également d'accord sur point: "Alors que ChatGPT peut identifier rapidement des tendances et des modèles, il peut avoir du mal à identifier des idées uniques ou innovantes qui peuvent ne pas répondre aux catégories ou cadres préexistants. L'intuition et la créativité humaine sont toujours essentielles pour reconnaître et apprécier les idées nouvelles".)

Rompre avec les interprétations standardisées.

ChatGPT peut sembler perspicace, mais … il ne pense pas! Il ne "comprend" pas vraiment. Il réorganise simplement les mots pour produire des séquences crédibles: les combinaisons les plus probables sont basées sur la quantité énorme d'informations qu'il a digérées. Même son essai le plus profond est le produit de statistiques et non de la réalité. Ses résultats sont modelés par les idéologies et les visions du monde telles qu'elles prévalent dans le corpus des connaissances qu'il a absorbées et par les formats utilisés dans sa formation (qui, accessoirement, ne sont pas divulgués). Il est très important de le garder à l'esprit. Lorsque nous demandons à ChatGPT d'interpréter les éléments de preuve, nous introduisons un biais: nous revenons aux structures de pensée dominantes. Lorsque nous pensons qu'il parvient à traiter et résumer les éléments de preuve – comme il l'a fait précédemment – c'est parce que c'est ainsi que ce type de tâche est généralement réalisée – dans les organisations et les contextes dans lesquels nous travaillons. C'est parce qu'il parodie notre langue et non pas parce qu'il offre la meilleure compréhension possible. Quels sont les risques possibles ? Ceux de passer à côté d'épistémologies, d'heuristiques alternatives, d'autres perspectives et d'autres angles. Ils ne sont peut-être pas aussi raffinés, mais ils pourraient être plus significatifs et pertinents. Finalement, les futures versions de ChatGPT pourraient être alimentées par des récits et des visions du monde alternatifs. Mais cela requiert la disponibilité de produits et de matériaux qui examinent différentes réalités et possibilités, en articulant différentes interprétations. Cela pourrait devenir un cercle vertueux! La communauté de l'évaluation peut avoir un rôle majeur pour révéler et propager des visions du monde et des interprétations alternatives, compte tenu de son exposition unique au changement. Plus encore, les évaluateurs travaillant dans des projets de développement, d'humanitaire et de consolidation de la paix qui sont exposés à différentes cultures, contextes et situations très complexes.

Faire les choses exactement "selon les règles" est à la fois la bénédiction et la malédiction de ChatGPT. Nous pourrions simplement opter pour la facilité, en faisant "plus de la même chose" avec une vitesse de traitement supérieure. Mais si de plus en plus de connaissances s'accumulent, en se basant sur les mêmes cadres, la résistance aux nouvelles interprétations pourrait s'accentuer encore davantage. Ou nous pourrions au contraire mettre à profit le temps gagné: une fois que ChatGPT nous a aidés à identifier "les conclusions et interprétations usuelles", nous pourrions utiliser notre intuition, notre imagination, notre connaissance de la réalité à bon escient: sont-elles valables? Devrions-nous interpréter les éléments de preuve différemment, sous différents angles? Quelles voix et perspectives devrions-nous valoriser le plus? Si nous nous en tenons à l'évaluation conventionnelle, les nouvelles incarnations de ChatGPT seront bientôt aussi bonnes que nous et nous remplaceront probablement en grande partie. Si nous libérons notre réflexion et notre créativité, en adoptant des approches alternatives, nous pourrions collaborer avec lui afin d'approfondir nos réflexions.

Vicente Plata

ConsultantDear Silva, you are absolutely right. Evaluators are mainly interpreters of what has happened, and consequently not only a "tick the box" in a "multiple choice" questionnaire. Of course we have to fill some forms and tables, organize information in a pre-agreed way, but the most important work is when we are able to find a "non previewed" result or impact. Most of our work is "standard work" and it has to be "up to standard", but there is a piece of "original work" that is what adds brightness to the evaluation work. And that cannot be done by AI, as AI always is an "average" of previous experiences.

Best

Vicente Plata

Alena Lappo Voronetskaya

Evaluation Officer (IAEA); Board Member (European Evaluation Society)Hi Silvia!

Thank you for the blog. Your review of the ChatGPT that highlights the strength and weaknesses of this software is greatly insightful. We shared the blog through the European Evaluation Society Newsletter today so that more members of evaluation community can participate in the discussion on technology and evaluation you raised through this blog.

Referring to the question you posed on whether AI in general is smart enough and can make our evaluation work easier, my answer is yes if we as evaluation practitioners understand its application and limitations.

Firstly, good evaluation always starts with the right evaluation questions and the methodology designed to answer these questions that take into account contextual factors, limitations, sensitivities, etc. I understand, that your example about coffee suggests that the value should have been placed on “time saving” and not on less “chores”. Methodologies such as Social Return on Investment (SROI) could go further in this example and place value, even financial, on the social activity of drinking coffee with friends beyond “time saving” if this is relevant to answer evaluation questions. This to say, “extra free time” and enriched “social life” should be of interest for the evaluation before the decision on whether to use AI technology for data collection/analysis and the search of the most appropriate software package.

Secondly, it is important to understand the limitations of applying AI and innovative technologies in our evaluation practice. To provide more insights into the implications of new and emerging technologies in evaluation, we discuss these subjects in the EvalEdge Podcast I co-host with my EES colleagues. The first episodes of the podcast focus on the limitations of big data and ways to overcome them.

Thirdly, the iterative process of interaction of evaluator and technology is important. As a good practice, data collected through innovative data collection tools triangulated with data collected through other sources. Machine learning algorithms applied, for example, to text analytics as discussed in one of the EES webinars on “Emerging Data Landscapes in M&E” need to be “trained” by human to code documents and to recognise the desired patterns.

Best regards,

Alena

RFE Réseau francophone de l'évaluation

Réseau francophone de l'évaluationBonjour Silva,

Merci beaucoup pour le lancement de cette discussion sur l'évaluation et Chat GPT. Je suis pressé de lire les réactions car ce sujet sera probablement abordé lors de la 5e édition du Forum international francophone de l'évaluation que le RFE (Réseau francophone de l'évaluation) organise avec la SOLEP (Société luxembourgeoise de l'évaluation et de la prospective), les 4, 5 et 6 juillet prochain, à Luxembourg.

Si le français n'est pas un problème pour toi, je t'invite à soumettre une proposition d'intervention d'ici le 30 mars. Cette invitation à nous adresser des propositions d'interventions vaut également pour l'ensemble des membres de la communauté EvalForward. Les dépôts se font en ligne : www.fife2023.rfevaluation.org.

Le thème de l'événement est "Évaluation et révolution numérique".

Jean-Marie Loncle

Secrétaire permanent du RFE